Projekt auf einen Blick

Bilddatenbanken werden immer grösser. Damit die Nutzerinnen und Nutzer möglichst alle – und vor allem passende – Bilder zu einem Suchbegriff finden, soll künftig künstliche Intelligenz Fotos in Datenbanken verschlagworten.

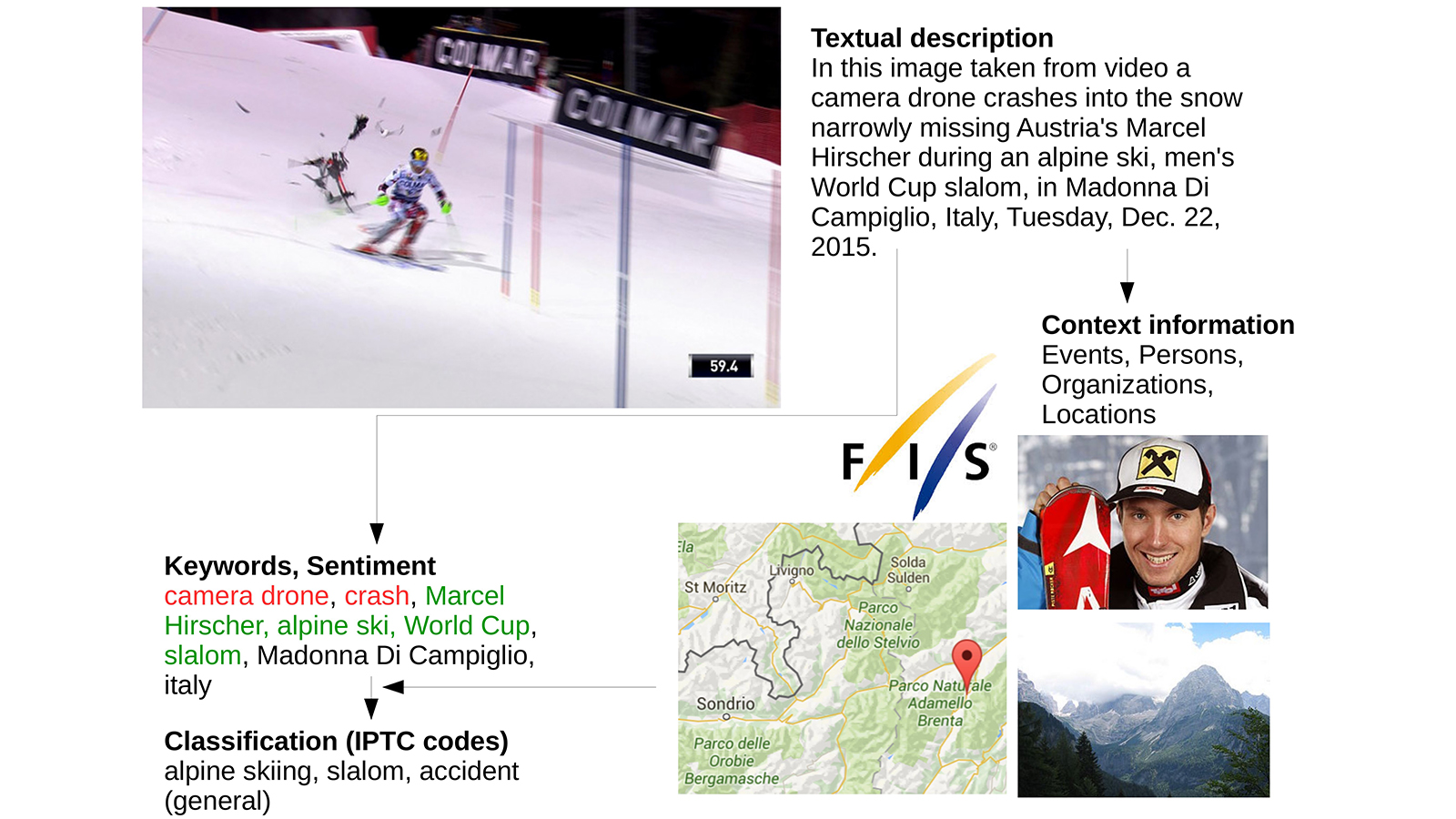

Das IMAGINE-Projekt entwickelt fortschrittliche Methoden für die automatische Extraktion von Metadaten aus Bildbeschreibungen und visuellen Inhalten sowie Techniken, um diese mit Verknüpfungen zu Personen, Organisationen und Orten anreichern zu können.

Projekt

IMAGINE: Cross-modal information extraction for improved image meta dataLead

Schweizerisches Institut für Informationswissenschaft (SII) Mehr über Schweizerisches Institut für Informationswissenschaft (SII)Projektleitung

Weichselbraun Albert Mehr über Weichselbraun AlbertTeam

Süsstrunk Norman Mehr über Süsstrunk Norman Kuntschik Philipp Mehr über Kuntschik PhilippForschungsfelder

Data Analytics Mehr über Data AnalyticsAuftrag/Finanzierung

Keystone AG, Innosuisse (Kommission für Technologie und Innovation KTI)Dauer

November 2015 – April 2017

Ausgangslage

Die Auffindbarkeit und Vermarktbarkeit von visuellen Inhalten – wie z. B. Fotografien, Grafiken und Videos – hängt grösstenteils von der Verfügbarkeit hochwertiger Metadaten ab, die es den Kundinnen und Kunden ermöglichen, effizient relevante Inhalte in umfangreichen Kollektionen zu lokalisieren. Die entsprechende Verschlagwortung erfolgt in der Praxis oft manuell und ist daher kostenintensiv und nur für einen geringen Anteil der verfügbaren Inhalte wirtschaftlich durchführbar. Um die Wahrscheinlichkeit, dass Bilder bei Suchvorgängen angezeigt (und somit gekauft) werden, zu erhöhen, wäre eine Qualitätskontrolle – vor allem bei visuellen Inhalten von Drittanbietern – von hoher Bedeutung, da diese Inhalte übermässig oft nicht-relevante Schlagworte enthalten.

Projektziel

Im Rahmen des Forschungsprojekts werden Technologien entwickelt, welche die automatische Extraktion von Information zu Bildern (Metadaten) aus Bildbeschreibungen ermöglichen und somit die oben beschriebenen Restriktionen beseitigen. Des Weiteren soll es möglich werden, Bilder automatisch mit externen Inhalten und Informationsquellen wie z. B. Wikipedia und Google Maps zu verknüpfen. Die Grafik stellt den entsprechenden Vorgang im Detail dar: Anhand der Bildbeschreibung werden vollautomatisch Events (FIS – Alpine Ski Weltcup), Personen (Marcel Hirscher) und Orte (Madonna Di Campiglio) sowie zugehörige Bilder und Kartenmaterial identifiziert und Schlagworte (camera drone, crash, slalom etc.) extrahiert. Diese können dann mit Hintergrundinformation auf Google Maps, Wikipedia etc. verknüpft werden, um die Bildsuche zu optimieren oder um Fotos und Illustrationen anhand von Themen, Personen, Orten oder Events zu gruppieren.

Zwischenstand

- 14. Februar 2018 – Der Artikel «Bilder finden statt suchen – Künstliche Intelligenz ermittelt Metadaten und Bildcluster» wird im PICTA-Magazin 1/2018 veröffentlicht.

- 12. Juli 2017 – Das Bündner Tagblatt veröffentlicht den Artikel «Intelligente Bildsuche», der das IMAGINE-Projekt vorstellt.

- 23. Juni 2017 – Karl Csoknyay stellt das IMAGINE-Projekt auf der IPTC Photo Metadata Conference 2017 vor.

- 14. Juni 2017 – Bafi.ch stellt das IMAGINE-Projekt im Artikel «Bessere Bildsuche dank künstlicher Intelligenz» vor.

- 8. Mai 2017 – Finales Projekttreffen in Chur und erfolgreicher Abschluss des IMAGINE-Projekts.

- 17. April 2017 – Die IMAGINE API wurde mit einem Testkorpus aus mehr als 100 000 Bildern erfolgreich getestet und evaluiert.

- 28. März 2017 – Wir haben die Zuverlässigkeit des im IMAGINE-Projekt verwendeten Named-Entity-Verlinkungssystems deutlich verbessert.

- 19. Januar 2017 – IMAGINE-Treffen in Zürich.

- 31. Oktober 2016 – Wir haben eine erste Arbeitsversion der IMAGINE API finalisiert.

- 31. Juli 2016 – Der zweite Projektbericht wird bei Innosuisse (Kommission für Technologie und Innovation KTI) eingereicht.

- 11. Juli 2016 – Eine erste Version der IMAGINE-Komponenten Keyword-Clustering und Datenanreicherung ist fertiggestellt.

- 29. Juni 2016 – Die Arbeit «Aspect-Based Extraction and Analysis of Affective Knowledge from Social Media Streams» («Aspektbasierte Extraktion und Analyse affektiven Wissens aus Social-Media-Streams») wird zur Veröffentlichung in der Zeitschrift IEEE Intelligent Systems angenommen.

- 22. Juni 2016 – Der Artikel «Detection of Valid Sentiment-Target Pairs in Online Product Reviews and News Media Coverage» («Erkennung valider Sentiment-Ziel-Paare in Online-Produktrezensionen und in der Medienberichterstattung») wird für die IEEE/WIC/ACM International Conference on Web Intelligence 2016 (Internationale Web-Intelligence-Konferenz, WI-2016) angenommen.

- 24. Mai 2016 – Die Arbeit «A Regional News Corpora for Contextualized Entity Discovery and Linking» («Ein regionaler Nachrichtenkorpus für kontextualisiertes Entity-Discovery und -Linking), die eine der Evaluierungskorpora des IMAGINE-Projekts beschreibt, wird an der Language Resources and Evaluation Conference (Konferenz für Sprachressourcen und -evaluierung, LREC-2016) vorgestellt.

- 19. April 2016 – Der IMAGINE-Algorithmus zur fortschrittlichen Keyword-Extraktion, passend für atypische Bereiche wie kreative Bilder, wird eingeführt.

- 1. April 2016 – Das Projektkonsortium hält ein Treffen in Zürich ab und arbeitet die nächsten Schritte für den ersten Prototyp heraus, der bis zum 30. September 2016 entwickelt werden soll.

- 29. Februar 2016 – Eine verbesserte Version der Jeremia Text-Vorverarbeitungskomponente (Spracherkennung, Satzspaltung, Tokenisierung, Part-of-Speech Tagging, Dependenz-Parsing), die im IMAGINE-Projekt zum Einsatz kommt, wird veröffentlicht.

- 15. Februar 2016 – Eine Modellversion der IMAGINE REST API wird zu Testzwecken veröffentlicht.

- 31. Januar 2016 – Der erste Projektbericht wird bei Innosuisse (Kommission für Technologie und Innovation KTI) eingereicht.

- 26. Januar 2016 – Der Artikel «A Regional News Corpora for Contextualized Entity Discovery and Linking» («Ein regionaler Nachrichtenkorpus für kontextualisiertes Entity-Discovery und -Linking), der die Named-Entity-Verlinkungskomponente von IMAGINE evaluiert, wird für die 10. Language Resources and Evaluation Conference (Konferenz für Sprachressourcen und -evaluierung, LREC 2016) angenommen.

- 5. Januar 2016 – Fertigstellung der Spezifikation der IMAGINE REST API.

- 5. November 2015 – IMAGINE-Auftakttreffen in Zürich.

Umsetzung

Das IMAGINE-Projekt entwickelt fortschrittliche Methoden für die automatische Extraktion von Metadaten aus Bildbeschreibungen und visuellen Inhalten sowie Techniken, um diese mit Verknüpfungen zu Personen, Organisationen und Orten anreichern zu können. Zusätzlich werden im Forschungsprojekt Ontologien zur Klassifikation von Bildern und Grafiken weiterentwickelt, welche die Auffindbarkeit der Bilder/Grafiken verbessern und Techniken für deren automatische Zuordnung zu den verschiedenen Klassen umsetzen sollen. Dadurch wird es z. B. möglich, Bilder anhand von Kategorien zu filtern. Die Klassifikation der Bilder erfolgt vollautomatisch durch Verfahren aus dem Gebiet der künstlichen Intelligenz.

Methoden aus dem Bereich der künstlichen Intelligenz erkennen und extrahieren automatisch Nennungen von Personen, Organisationen, Events und Lokationen aus textuellen Bildbeschreibungen. Diese werden mit automatisch extrahierten Schlüsselwörtern und Hintergrundwissen aus Wikipedia kombiniert und verbessern somit die Auffindbarkeit von relevanten visuellen Inhalten.

Resultate

Neben einer deutlich verbesserten Bildsuche soll es auch möglich werden, Bilder automatisch nach Themen zu gruppieren. Die Verknüpfungen zwischen visuellen Inhalten und Hintergrundinformation aus Quellen wie Wikipedia oder der International Movie Database sind wiederum die Basis für komplexe Suchen.

Die Nutzerinnen und Nutzer von Keystone-Produkten haben somit den Vorteil einer benutzerfreundlicheren Bildsuche, die bessere Ergebnisse liefert und es ermöglicht, Bilder nach den für Kundinnen und Kunden relevanten Kriterien zu gruppieren. Die Industriepartner profitieren von einer höheren Kundenzufriedenheit und geringeren Kosten bei der Erfassung der Bilder, da manuelle Arbeitsschritte durch intelligente Algorithmen ergänzt werden. Des Weiteren ermöglicht IMAGINE auch die kostengünstige Erfassung von Bildern, die von Drittanbietern zur Verfügung gestellt werden, wodurch sich deren Metadatenqualität ebenfalls deutlich verbessern wird.

Team

Neben den angeführten aktuellen Mitarbeitenden der FH Graubünden waren folgende ehemalige Projektmitarbeitende und externe Personen am Projekt beteiligt:

- Karl Csoknyay

- Lukas Kobel

- Philipp Kuntschik

- Markus Läng

- Fabian Odoni

- Rütti Sven

Weiterführende Information

Beteiligte

Das IMAGINE-Projekt wird von Innosuisse (Kommission für Technologie und Innovation KTI) des Eidgenössischen Departements für Wirtschaft, Bildung und Forschung gefördert.

Zu den Projektpartnern gehören die Hochschule für Technik und Wirtschaft Chur (Institut für Informationswissenschaft) und die KEYSTONE AG Zürich, der Schweizer Anbieter mit dem umfangreichsten Angebot an visuellen Inhalten – Fotos, Grafiken, Videos.