Projekt auf einen Blick

Benutzerpositionsabhängige adaptive Darstellung von 3D-Daten (z. B. CAD-Werkstück) ohne zusätzliche stereoskopische Hardware.

Projekt

Benutzerpositionsabhängige WerkstückausrichtungLead

Institut für Photonics und Robotics (IPR) Mehr über Institut für Photonics und Robotics (IPR)Projektleitung

Roebrock Philipp Mehr über Roebrock PhilippBeteiligte

IPR Institut für Photonics und RoboticsTeam

Birk Udo Mehr über Birk UdoForschungsfelder

Bildverarbeitung Mehr über Bildverarbeitung

Ausgangslage

3D-Vision-Module haben sowohl im Maschinenbau als auch im Home-Entertainment-Bereich aufgrund der erforderlichen zusätzlichen Hardware (Bildaufnahme, Virtual-Reality-Headsets, 3D-Brillen) nur begrenzten Erfolg. In den letzten Jahren haben vor allem die Gaming- und Bildungsbranche, wo Virtual- oder Augmented-Reality zum Einsatz kommen, von solch spezialisierter Headgear (z. B. VR-Brillen) profitiert. Viele andere industrielle und biomedizinische Anwendungen wie z. B. Computer Aided Design (CAD) oder tomographische Datendarstellung haben die erweiterten 3D-Rendering-Fähigkeiten heutiger Computerhardware bisher jedoch noch nicht voll ausgeschöpft.

Projektziel

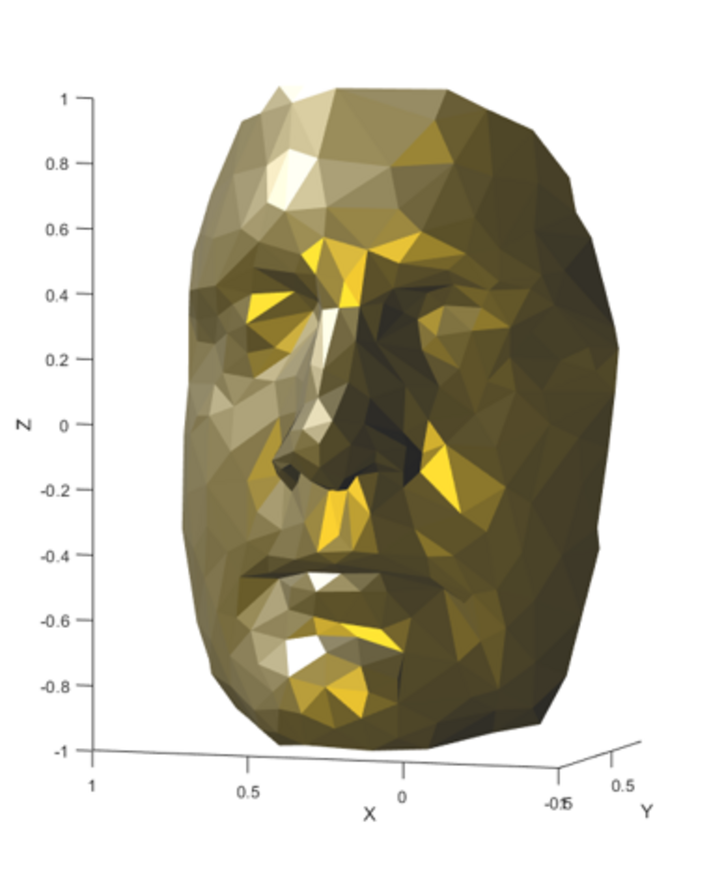

Dem Benutzer sollen 3D-Daten wie z. B. mit CAD-Programmen entwickelte Werkstücke in einer quasi-realistischen 3D-Ansicht präsentiert werden. Die Ansicht auf dem Bildschirm wird dabei durch die Kopfbewegungen der betrachtenden Person gesteuert. So ergibt sich – ähnlich wie bei einem Hologramm – der Eindruck eines 3D-Werkstücks. Zum Beispiel wird das Objekt bei seitlicher Kopfbewegung seitlich gedreht, sodass nun das Werkstück von der Seite betrachtet werden kann.

Umsetzung

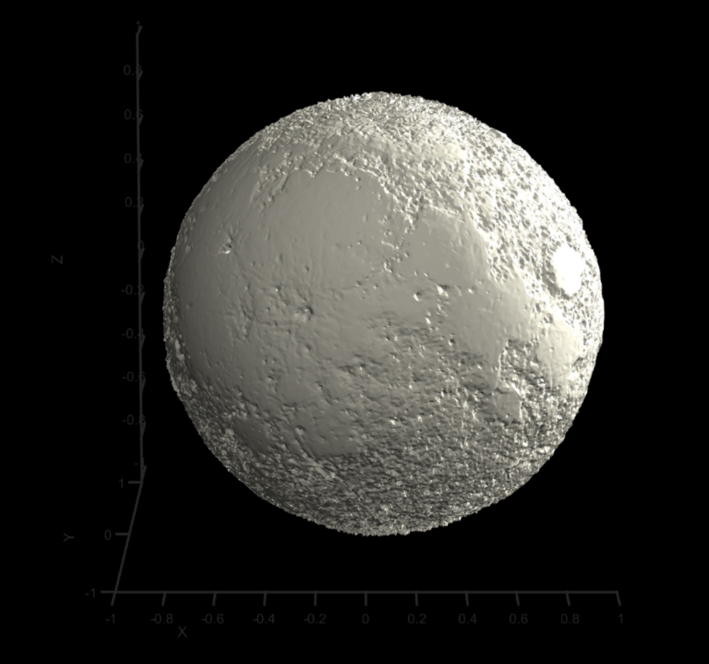

Wir verwenden Standard-Desktop-PC-Hardware (Monitor und Webcam), um von der Benutzerposition abhängige Projektionen von 3D-Daten ohne zusätzliche Headgear anzuzeigen. Die Benutzerposition wird anhand von Webcam-Bildern erkannt und die gerenderten 3D-Daten (d. h. die Ansicht) an die entsprechende Benutzerposition angepasst, was zu einem Quasi-Virtual-Reality-Rendering führt, wenn auch ohne den 3D-Effekt einer richtigen 3D-Kopfbedeckung.

Der Ansatz hat viele Anwendungen, von der medizinischen Bildgebung über Konstruktion und CAD bis hin zu Architektur, Ausstellungen, Kunst und Performances. Abhängig von der Position des Benutzers, d. h. der erkannten Kopfposition, werden die Daten unterschiedlich dargestellt, um den Blickwinkel (Zoom) und die Richtung des Benutzers zuzuordnen. Wenn der Benutzer seinen Kopf vor den Monitor bewegt, werden verschiedene Merkmale des gerenderten Objekts sichtbar. Wenn sich der Benutzer dem Bildschirm nähert, wird der Blickwinkel der gerenderten Daten verringert, was zu einer vergrösserten Version des gerenderten Objekts führt.

Resultate

Das Projekt wurde als Forschungsprojekt gefördert durch die Fachhochschule Graubünden durchgeführt. Die Ergebnisse sind in einer wissenschaftlichen Arbeit publiziert.

Team

Weiterführende Information

Beteiligte